هل لاحظت مؤخرًا كيف أصبح الذكاء الاصطناعي جزءًا من كل شيء؟ من كتابة رسائل البريد الإلكتروني، إلى توليد الصور، وحتى تحليل بيانات أعمالك؟

لكن خلف كل هذه المزايا المذهلة، هناك وجه خفي لا ينتبه إليه الكثيرون: الخصوصية.

في عالم تتحدث فيه الآلات أكثر مما نستوعب، أصبحت بياناتنا الوقود الأساسي الذي يحرك أدوات الذكاء الاصطناعي. ومع تزايد استخدام هذه الأدوات في الخليج — سواء في التعليم أو الأعمال أو حتى الترفيه — تبرز تساؤلات جوهرية:

كيف نحافظ على خصوصيتنا؟ ومن يضمن أن معلوماتنا الشخصية لا تُستخدم بطريقة لا نعلمها؟

في هذا الدليل العملي الشامل، سنكشف كيف تحمي خصوصيتك وأنت تستخدم أدوات الذكاء الاصطناعي، بخطوات واقعية تناسب المستخدم الخليجي — سواء كنت رائد أعمال، أو طالبًا، أو مجرد مستخدم فضولي للتقنيات الحديثة.

لماذا تمس أدوات الذكاء الاصطناعي خصوصيتنا؟

البيانات هي الوقود

كل أداة ذكاء اصطناعي تتعلم من البيانات التي تزودها بها — نصوص، صور، عادات، وحتى نبرة صوتك أحيانًا.

لكن هذه البيانات لا تُستخدم فقط لتحسين تجربتك، بل قد تُخزَّن وتُحلَّل وتُشارك مع أطراف أخرى لأغراض تجارية أو بحثية.

ما يختلف في السياق الخليجي

في الخليج، تختلف نظرة المستخدمين للخصوصية عن باقي العالم.

الكثير من المؤسسات في السعودية والإمارات والبحرين تتجه نحو التحول الرقمي السريع، لكن وعي المستخدمين بخصوصية بياناتهم لا يزال في بدايته.

العديد من الشركات الإقليمية تعتمد على أدوات عالمية قد لا تلتزم بالقوانين المحلية الخاصة بالبيانات.

أمثلة واقعية

– في عام 2024، واجه أحد المشاريع في دبي انتقادات بعد استخدامه أداة تحليل بيانات ذكاء اصطناعي حفظت محادثات العملاء دون إذن.

– مستخدمون في السعودية لاحظوا أن أدوات كتابة المحتوى تحفظ المسودات تلقائيًا حتى بعد حذفها.

هذه ليست مجرد حوادث فردية — إنها إشارات على ضرورة التعامل مع أدوات الذكاء الاصطناعي بحذر ووعي أكبر.

الفئات الثلاث للمستخدمين وتأثير كل فئة

1. المستخدم الفردي في الخليج

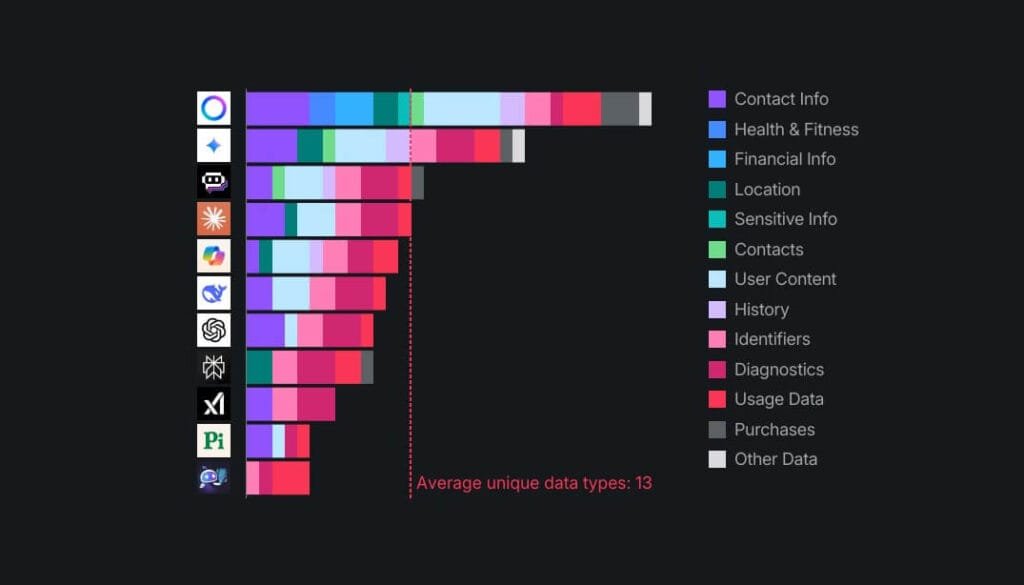

غالبًا ما يستخدم أدوات مثل ChatGPT أو Copilot أو Midjourney دون قراءة شروط الخصوصية.

🔹 المخاطر: إدخال معلومات شخصية أو صور عائلية قد تُستخدم لتدريب النماذج.

🔹 ما يجب فعله: استخدم أدوات مجهولة الهوية (Anonymous Mode) وتجنب مشاركة أي معلومة شخصية أو مالية.

2. المؤسسات الصغيرة والمتوسطة

هذه الفئة هي الأكثر عرضة للمخاطر بسبب قلة الوعي بأمن البيانات.

🔹 مثال: شركة تسويق في الرياض تستخدم أداة AI لتحليل بيانات العملاء — دون اتفاقية حماية بيانات واضحة.

🔹 الحل: اعتماد سياسة “عدم إدخال أي بيانات حقيقية في الأدوات التجريبية”.

3. الشركات الكبرى

رغم أن لديها أقسام أمن معلومات، إلا أن المخاطر لا تختفي.

🔹 التحدي: التوازن بين كفاءة الأدوات والامتثال للتشريعات الخليجية.

🔹 الحل: بناء نظام حوكمة خصوصية داخلي يشمل الذكاء الاصطناعي.

أبرز 10 أخطاء شائعة في حماية الخصوصية عند استخدام أدوات AI

| ❌ الخطأ الشائع | ✅ ما يجب فعله بدلاً منه |

|---|---|

| إدخال معلومات شخصية في المحادثات | استخدم بيانات تجريبية أو رمزية |

| الاعتماد الكامل على الذكاء الاصطناعي بدون مراجعة | راجع كل ناتج قبل مشاركته |

| تجاهل إعدادات الخصوصية في الأداة | افحص إعدادات الخصوصية قبل الاستخدام |

| مشاركة الحساب بين أكثر من شخص | استخدم حسابًا منفصلًا |

| استخدام شبكات عامة | استخدم VPN أو شبكة آمنة |

| عدم حذف السجلات القديمة | امسح السجل دوريًا |

| إدخال بيانات العمل الحساسة | استخدم بيئة منفصلة للعمل |

| الوثوق بالإعلانات الدعائية للأدوات | تحقق من سياسة الخصوصية |

| تسجيل الدخول عبر حسابات التواصل | أنشئ حسابًا مخصصًا للأداة |

| تجاهل التحديثات الأمنية | حدّث أدواتك بانتظام |

خطوات عملية لحماية خصوصيتك — دليل المستخدم الخليجي

الخطوة 1: اقرأ قبل الموافقة

تبدو سياسة الخصوصية طويلة ومملة؟ صحيح، لكنها تحتوي على أهم بند: كيف تُستخدم بياناتك.

الخطوة 2: لا تدخل بيانات شخصية أو حساسة

قاعدة ذهبية: أي معلومة لا ترغب في أن تصبح عامة، لا تُدخلها في أي أداة AI.

الخطوة 3: فعّل أدوات التشفير أو VPN

خاصة إذا كنت تستخدم شبكات عامة في المقاهي أو الفنادق.

الخطوة 4: احذف السجلات بانتظام

بعض الأدوات تحتفظ بمحادثاتك لأغراض “تحسين الأداء” — لا تسمح بذلك إن لم يكن ضروريًا.

الخطوة 5: استخدم أدوات “الخصوصية أولاً”

مثل:

- DuckDuckGo AI Chat 🦆

- PrivateGPT (تشغيل محلي دون رفع البيانات)

- Brave Search AI

قائمة التحقق السريعة 🧾

☑️ راجعت إعدادات الخصوصية

☑️ لا أستخدم بيانات حقيقية

☑️ فعّلت التحقق بخطوتين

☑️ أحدثت الأداة لآخر إصدار

☑️ استخدم VPN أو اتصال آمن

الإطار القانوني والتنظيمي في الخليج العربي

السعودية 🇸🇦

أصدرت نظام حماية البيانات الشخصية (PDPL) عام 2023، الذي يُلزم المؤسسات بالحصول على موافقة صريحة قبل جمع البيانات.

الإمارات 🇦🇪

أطلقت القانون الاتحادي لحماية البيانات الشخصية 2022 ضمن استراتيجية الإمارات للذكاء الاصطناعي.

يُركّز على حق المستخدم في معرفة كيف تُستخدم بياناته وأين تُخزن.

الكويت وقطر والبحرين

تتبنى تشريعات مشابهة، وتعمل على تطوير أطر قانونية لتقنيات الذكاء الاصطناعي ضمن “رؤية الخليج 2030”.

✅ نصيحة: إذا كنت صاحب مشروع خليجي، فاستعن باستشارة قانونية لضمان توافق استخدام أدوات AI مع قوانين البيانات المحلية.

مستقبل الخصوصية في عصر الذكاء الاصطناعي

بحلول عام 2030، ستنتقل أدوات AI من “جمع البيانات” إلى “حماية البيانات”.

تقنيات مثل التعلم الفيدرالي (Federated Learning) والتشفير التفاضلي (Differential Privacy) ستتيح تدريب النماذج دون الحاجة لمشاركة بيانات المستخدم فعليًا.

لكن تظل المسؤولية الأكبر على المستخدم نفسه:

الذكاء الاصطناعي لن يحميك ما لم تحمِ نفسك أولًا.

الأسئلة الشائعة

هل يمكن أن تستغل أدوات AI بياناتي دون إذني؟

نعم، إن لم تحدد إعدادات الخصوصية بوضوح أو وافقت ضمنيًا على شروط غير دقيقة.

هل هناك أدوات تحافظ على الخصوصية فعليًا؟

نعم، مثل PrivateGPT وDuckDuckGo AI، تعمل محليًا دون إرسال البيانات إلى الخوادم السحابية.

هل القوانين الخليجية تحميني؟

نعم، ولكن عليك الإبلاغ رسميًا في حال أي انتهاك. الوعي الذاتي هو خط الدفاع الأول.

هل استخدام VPN كافٍ؟

يساعد كثيرًا، لكنه لا يغني عن الحذر في نوعية البيانات التي تُدخلها.

اقرأ أيضًا: 👇

الذكاء الاصطناعي في الأجهزة الحديثة: ذكاء زايد عن اللزوم؟ — اكتشف كيف غيّر الذكاء الاصطناعي طريقة عمل أجهزتنا اليومية وما إن كان “الذكاء الزايد” نعمة أم عبء.

خاتمة

الذكاء الاصطناعي لم يُخلق ليهدد خصوصيتنا، بل ليخدمنا — بشرط أن نستخدمه بذكاء.

فكما نغلق باب المنزل لحماية ممتلكاتنا، يجب أن نغلق “أبواب البيانات” لحماية أنفسنا من التسرّب أو الاستغلال.

💡 ابدأ اليوم بتطبيق الخطوات الخمس السابقة، وستضمن أن رحلتك في عالم الذكاء الاصطناعي آمنة، ذكية، وواعية.